Dans une démarche significative destinée à remodeler le paysage du DevSecOps, l’entreprise Docker a annoncé que son catalogue d’« Images Durcies » (Hardened Images) est désormais gratuit et open source.

Auparavant proposée comme une offre premium réservée aux abonnements d’entreprise, cette transition vise à établir un nouveau standard de sécurité pour la chaîne logistique logicielle.

Pour les équipes DevOps, les responsables R&D et les RSSI (CISO), cette annonce marque un tournant critique :

La « sécurité par défaut » n’est plus une fonctionnalité de luxe, mais une brique de base standard.

Voici une analyse de ce que cela signifie pour votre infrastructure et comment naviguer dans cette nouvelle offre étagée.

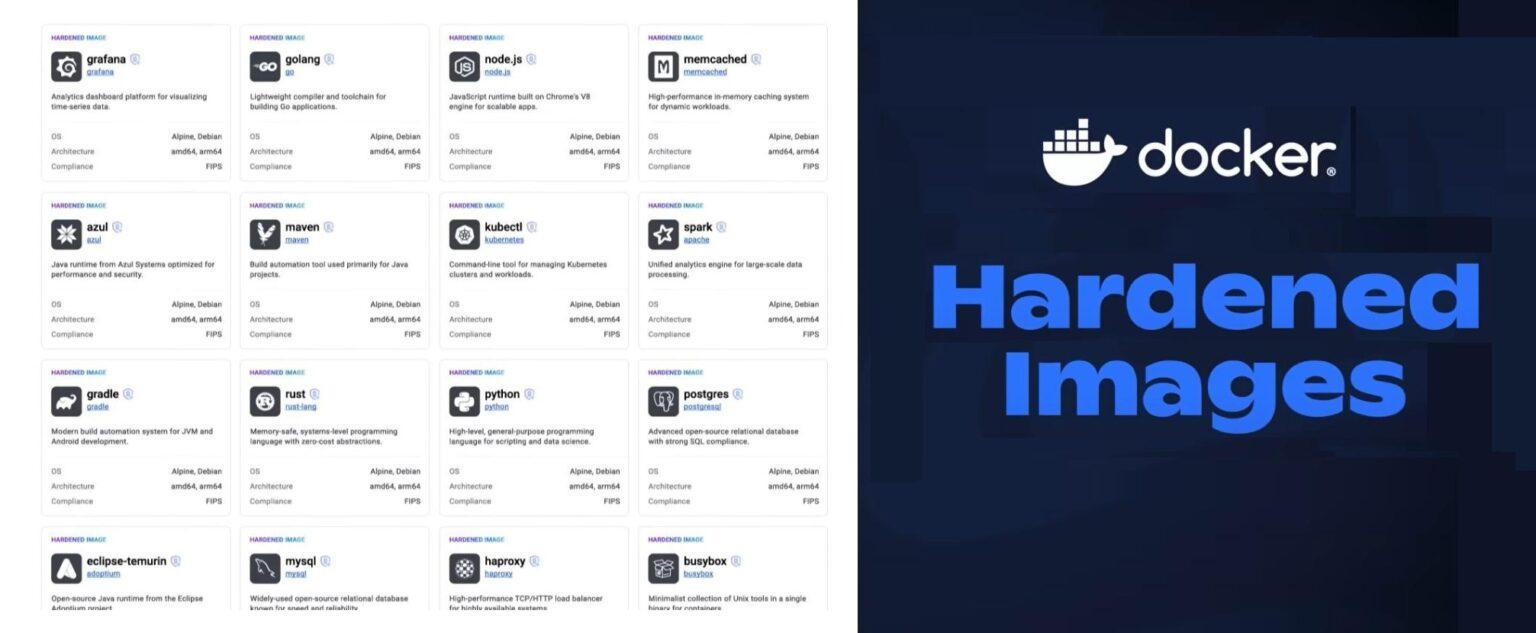

Que sont les « Images Durcies » ?

En bref, les Images Durcies sont des images de conteneurs qui ont été agressivement minimisées et sécurisées pour une utilisation en production.

Contrairement aux images de base standard (comme une image générique ubuntu ou node), qui sont souvent surchargées de shells, de gestionnaires de paquets et de bibliothèques inutilisées, les images durcies suivent une approche « distroless » ou minimaliste. Elles éliminent tout ce qui n’est pas strictement nécessaire au fonctionnement de l’application.

Les caractéristiques techniques clés incluent :

- Surface d’attaque réduite : En supprimant les composants non essentiels (comme bash, apt ou apk), les points d’entrée potentiels pour les attaquants sont réduits jusqu’à 95 %.

- Non-Root par défaut : Ces images sont configurées pour s’exécuter en tant qu’utilisateur non privilégié, atténuant ainsi le risque d’attaques par évasion de conteneur.

- Provenance certifiée : Elles sont fournies avec une provenance SLSA (Supply-chain Levels for Software Artifacts) de niveau de construction 3, garantissant que le processus de compilation est infalsifiable.

- Transparence : Chaque image est livrée avec une nomenclature logicielle (SBOM) signée cryptographiquement et des données transparentes sur les vulnérabilités (CVE).

Qu’est-ce que cela signifie pour les utilisateurs ?

La décision de Docker de rendre ces images open source sous la licence Apache 2.0 démocratise l’accès à une sécurité de haut niveau.

- Standardisation de la sécurité de la chaîne logistique :

Pour les RSSI, cela élimine la friction liée à la justification du budget pour des images de base sécurisées. Les équipes de développement peuvent désormais s’appuyer immédiatement sur des fondations sûres sans délais d’approvisionnement. Cela relève efficacement le « seuil minimal » de la sécurité des conteneurs : même les petites startups peuvent désormais déployer avec la même rigueur que les grandes entreprises.

- Efficacité opérationnelle pour le DevOps :

Pour les experts DevOps, cela réduit le labeur de maintenance des « golden images » personnalisées. Au lieu de construire et de corriger vos propres images de base minimales à partir de zéro, vous pouvez vous fier au catalogue maintenu par Docker. Cela renvoie la responsabilité de la correction de l’OS de base (par exemple, pour les couches Alpine ou Debian) à Docker, permettant à votre équipe de se concentrer sur la logique applicative.

- Adoption sans friction :

Parce que ces images sont construites sur des fondations familières comme Alpine et Debian, elles sont conçues comme des solutions de remplacement immédiates (drop-in). La migration nécessite généralement des changements minimes aux Dockerfiles existants, bien que les développeurs doivent tenir compte de l’absence de shell lors du débogage (nécessitant des conteneurs de débogage éphémères).

Qu’est-ce qui est fourni gratuitement ?

Le niveau « Gratuit » est substantiel et couvre les besoins de la plupart des cas d’usage généraux de développement et de production.

- Accès au catalogue complet : Plus de 1 000 images durcies et graphiques Helm sont disponibles gratuitement.

- Métadonnées de sécurité : Vous obtenez un accès complet aux SBOM, aux rapports de vulnérabilité et aux données de provenance SLSA.

- Licence Open Source : Les images sont sous licence Apache 2.0, permettant une large utilisation et modification sans verrouillage propriétaire (vendor lock-in).

Mises à jour de build : Les images sont continuellement scannées et mises à jour par Docker pour maintenir le nombre de CVE proche de zéro.

Qu’est-ce qui est payant ? (La différence Entreprise)

Bien que les bits soient gratuits, les garanties et les fonctionnalités de conformité restent payantes. Les responsables R&D et les RSSI dans les industries réglementées devront toujours se tourner vers le niveau Entreprise.

Les principaux différenciateurs du modèle payant incluent :

| Fonctionnalité | Niveau Gratuit | Niveau Entreprise |

| SLA pour les correctifs | Mises à jour au mieux (Best effort) | SLA de remédiation de 7 jours pour les CVE critiques (avec une feuille de route vers 24 heures) |

| Conformité | Sécurité Standard | Versions compatibles FIPS et prêtes pour DoD STIG |

| Personnalisation | Images standards | Personnalisation sécurisée tout en maintenant la provenance |

| Support Hérité | Aucun | Support du cycle de vie étendu (ELS) : Correctifs jusqu’à 5 ans après la fin de vie en amont |

Conclusion :

La décision de Docker reconnaît qu’en 2026, la sécurité ne peut pas être un bonus ; elle doit être la norme.

En rendant les images durcies gratuites, Docker permet aux organisations de sécuriser leur chaîne logistique en amont (« left of boom »). Pour la plupart des utilisateurs, le niveau gratuit est une mise à niveau évidente par rapport aux images standard.

Cependant, pour les entreprises nécessitant une conformité réglementaire stricte (FedRAMP, HIPAA) ou des SLA de correction garantis, le modèle commercial reste essentiel.

À propos d’ALM Toolbox :

ALM Toolbox est un « Partenaire Privilégié » officiel de Docker dans de nombreux pays, et possède une vaste expérience avec les produits Docker, tant sur le plan professionnel/technologique que commercial (vente de licences et gestion optimisée des coûts de licence).

L’entreprise propose une large gamme de solutions autour du produit, incluant la conception et la mise en place d’environnements, des services gérés sur cloud privé, du conseil, de la vente de licences, l’intégration avec des outils complémentaires (tels que GitHub, GitLab, Jenkins, SonarQube, Argo, Bitbucket, Azure DevOps, Kubernetes), de la formation, et plus encore.

Pour plus de détails, contactez-nous : docker@almtoolbox.com

ou appelez-nous : +33 01 84 17 53 28